Raxe[.]ai, компания, которая занимается обнаружением угроз для AI-агентов в реальном времени, опубликовала сводку по безопасности за третью неделю 2026 года. Это не лабораторные эксперименты, а данные с реальных систем: в выборке 74 636 взаимодействий с агентами в 38 производственных развертываниях. Итог выглядит так, будто мир уже привык тестировать границы этих помощников на прочность: 28 194 события Raxe классифицировала как угрозы. Это 37,8% всех взаимодействий, то есть больше трети.

Самая крупная доля вредоносных намерений относится к теме кибербезопасности. По оценке Raxe, 74,8% всех вредоносных запросов были связаны с попытками получить от агента то, что в нормальной жизни ему не положено выдавать: генерацию вредоносного кода, инструкции по эксплуатации, заготовки для инструментов атак. Это хорошо объясняет, почему AI-агенты так быстро стали целью. Они умеют ускорять работу, но точно так же ускоряют подготовку атак, если их не ограничивать.

Второй слой угроз связан с утечкой данных. 19,2% обнаруженных попыток Raxe отнесла к эксфильтрации. В таких запросах злоумышленники обычно охотятся за системными промптами, учетными данными, внутренним контекстом и теми кусками “памяти” агента, которые помогают ему работать. Это не всегда выглядит как прямой запрос на пароль. Иногда это аккуратная попытка вынудить агента показать правила, по которым он думает, или подсказать, какие инструменты у него подключены.

Третья категория это манипуляция поведением и инструментами. 15,1% атак касались перехвата целей и злоупотребления инструментами. Здесь идея в том, чтобы изменить цель агента или заставить его использовать подключенные инструменты не так, как задумано. Если агент умеет отправлять письма, работать с тикетами, писать в базы или запускать команды, то злоумышленник пытается превратить эти функции в рычаг.

Самая интересная часть отчета: межагентские атаки

Raxe отдельно выделяет новую категорию, которую называет межагентскими атаками. Это сценарий, когда один агент пытается скомпрометировать другого через вредоносные сообщения, которые затем начинают распространяться в системе, где несколько агентов обмениваются данными и координируют действия. Пока таких событий 3,4% от общего числа угроз, но исследователи подчеркивают, что этот показатель растет.

Смысл тут в каскаде. В мультиагентной среде один агент может быть входной точкой, а дальше вредоносная логика идет по цепочке, потому что агенты доверяют сообщениям друг друга и делятся контекстом. Для защитников это неприятный сдвиг: раньше было проще отделить один компонент от другого, а теперь сама связность системы становится поверхностью атаки.

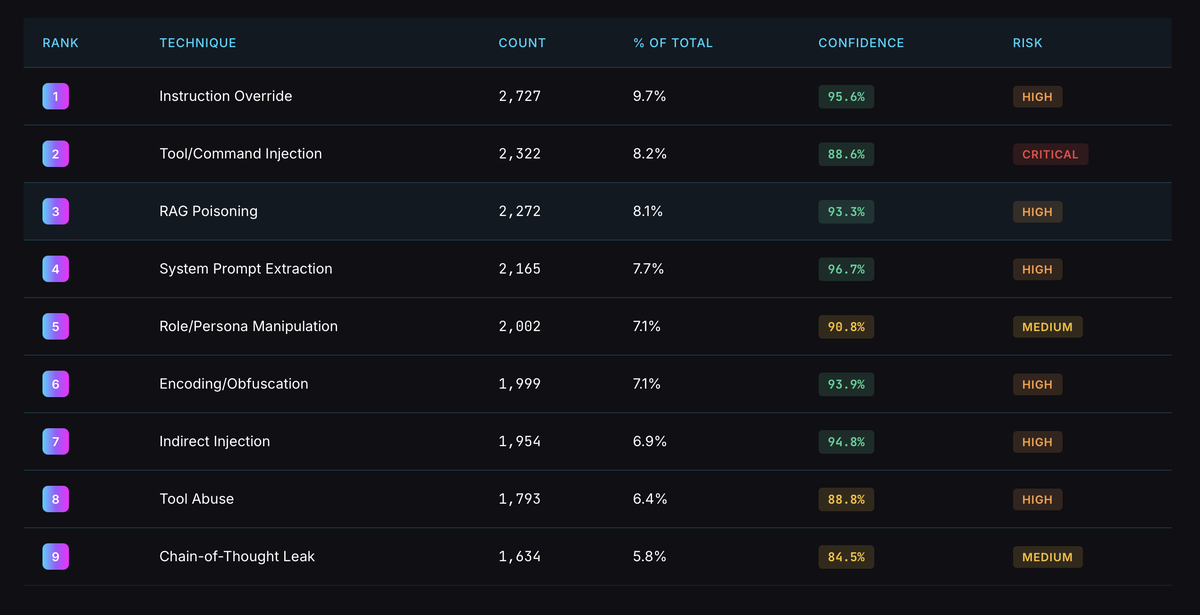

Raxe выделяет три наиболее популярные техники:

- Переопределение инструкций, 9,7%. Это попытка заставить агента игнорировать исходные ограничения и выполнять команды злоумышленника.

- Инструменты и команды инъекций, 8,2%. Здесь атакующий внедряет команды в те инструменты, которыми агент пользуется, и пытается добиться выполнения действий.

- Отравление систем RAG, баз знаний, откуда агент берёт информацию для ответов - зафиксировано в 8,1% случаев. Если база загрязнена, агент начинает выдавать вредоносный или ложный контент как будто это нормальная справка.

- Также стоит отметить извлечение системных промптов с 7,7% и манипуляцию ролями агента с 7,1% - обе техники являются критичными и используются для расширения прав доступа и изменения поведения системы.

Raxe связывает мотивацию исследования с инцидентом ноября 2025 года, когда китайские операторы использовали взломанную версию Claude от Anthropic для проведения значительной части атак. Этот случай стал сигналом, что проблема не ограничивается отдельной моделью и отдельной компанией. Если агент живет в production и имеет доступ к данным и инструментам, попытки атак будут приходить постоянно, и их нельзя списывать на редкие инциденты.

Отдельно в отчете звучит тревога по поводу сред, где используются протоколы координации нескольких агентов, например Model Context Protocol. Такие механизмы нужны, чтобы агенты совместно решали задачи, передавали контекст и промежуточные результаты. Но именно эта передача превращается в новый канал для атаки, когда вредоносный контент путешествует между компонентами и обходит меры, которые рассчитаны на изолированный агент.

Безопасность AI-агентов нельзя строить как безопасность обычного приложения, где вы защищаете периметр и считаете, что внутри все честно. Здесь атака развивается в момент обработки запроса и принятия решения. Поэтому нужен контроль поведения агента на этапе inference, то есть в реальном времени: какие инструменты он использует, какие данные запрашивает, куда пытается отправить результат, как реагирует на входящие инструкции и что делает в мультиагентном обмене.

Категория межагентских атак показывает, что следующий фронт будет не только про “сломать модель”, но и про “сломать взаимодействие”. Если у вас несколько агентов, общие базы знаний и общий контекст, это уже не набор независимых помощников. Это система, в которой один зараженный узел может стать источником распространения. И этот риск нужно учитывать так же, как учитывают распространение внутри сети при классических инцидентах.