Исследователи из Университета Олбани опубликовали работу, которая помогает по-новому смотреть на то, как ИИ-агенты хранят и обрабатывают информацию. В научной среде долго считалось, что внутренние представления нейросетей устроены сравнительно просто, как гладкие поверхности небольшой размерности. Но в новом анализе команда показала другую картину: внутри модели получается слоистое пространство, где рядом существуют области разной размерности, как лоскутное одеяло.

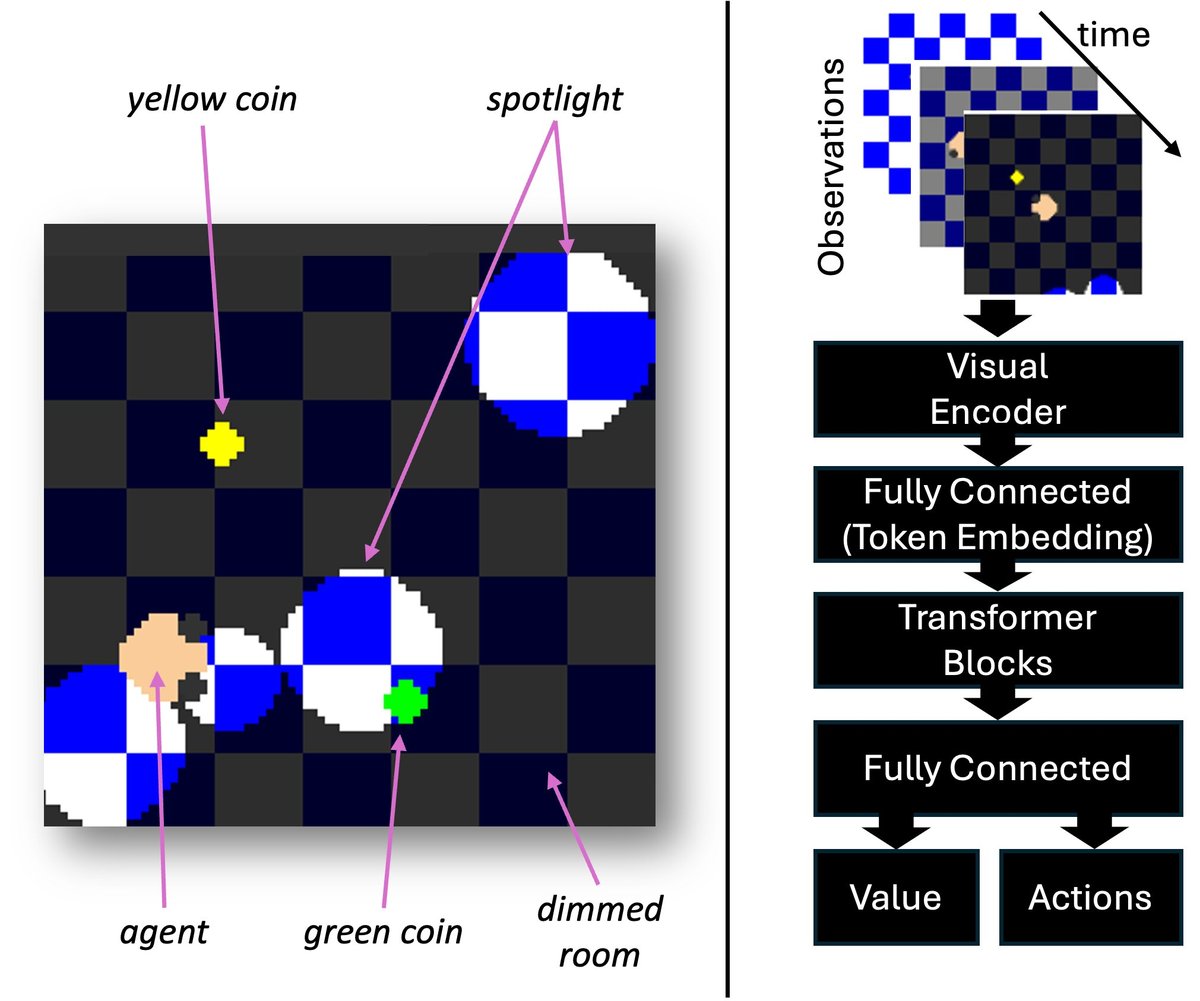

Исследователи изучали агента на базе трансформера, обученного с подкреплением, который действовал в игровой среде на память и навигацию. Агент собирал монеты и избегал движущихся прожекторов. Каждый кадр, который видела модель, превращался в своего рода токен, и ученые смотрели, как эти токены “раскладываются” по внутренним слоям сети.

Они обнаружили четыре устойчивых кластера по геометрической размерности. И главное, эти изменения совпадали с поведением ИИ-агента. Когда обстановка простая или агент уже выбрал стратегию действий, внутренняя геометрия становилась более компактной и низкоразмерной. Когда на экране становилось тесно, появлялись новые прожекторы или приходилось выбирать между несколькими вариантами, размерность резко возрастала. Исследователи описывают это как момент неопределенности, когда модели буквально нужно больше места для размышления.

Авторы используют метод, который называют преобразованием роста объема, и показывают, что поведение модели хуже объясняется старой интуицией про гладкие поверхности. Вместо плавных переходов возникают скачки между слоями разной размерности. По сути, у модели есть режим уверенности и режим сомнений, и их можно наблюдать как геометрический сигнал.

Для практики это может стать новым инструментом интерпретации. Если инженеры умеют отслеживать такие скачки в реальном времени, они получают способ понимать, когда агенту сложно и когда он начинает “перебирать варианты”. В безопасности это особенно интересно: состояние замешательства обычно делает систему более уязвимой к ошибкам и внешним воздействиям, например к попыткам внедрить ложный контекст или заставить агента действовать не так, как задумано.

Работа опубликована как препринт на arXiv, то есть это еще не финальная версия, но сама идея выглядит перспективно: измерять не только ответы ИИ-агента, но и его внутреннюю сложность в момент принятия решения.